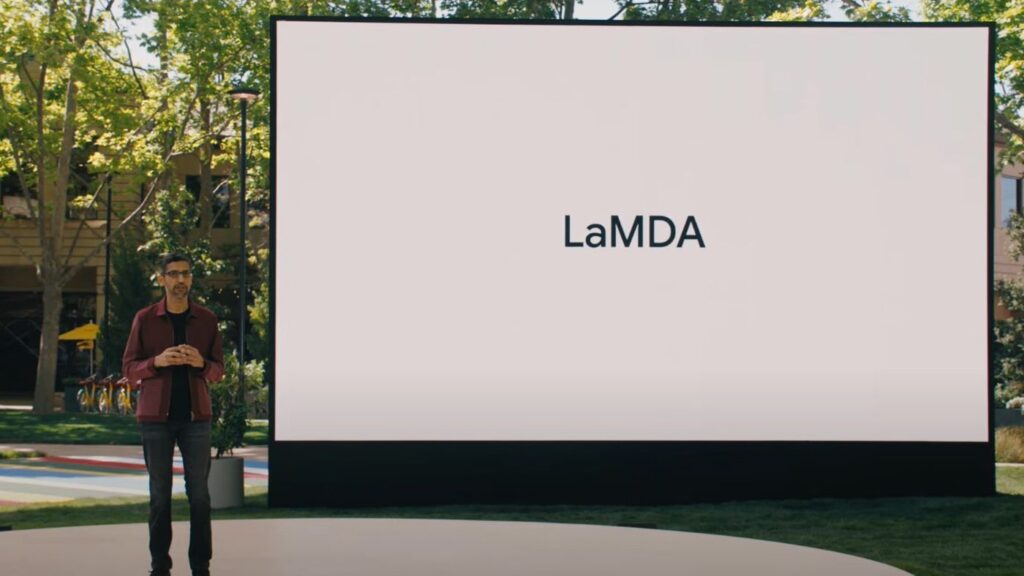

De acordo com informações do jornal britânico, The Washington Post, um funcionário do Google teria sido suspenso por afirmar que a LaMDA, Inteligência Artificial de processamento de linguagem da empresa, teria se tornado “autoconsciente”.

Conforme relata a reportagem, Blake Lemoine, engenheiro da Responsible AI (IA Responsável), pertencente ao Google, teve seu cargo colocado em cheque na última terça-feira, 06 de junho, sob a alegação de ter violado os termos de confidencialidade da empresa. Para Lemoine, no entanto, o que ele fez foi lançar luz sobre uma discussão tecnológica e, sobretudo, ética.

A princípio, o trabalho de Blake com a LaMDA consistia na realização de testes, feitos com o objetivo de analisar se a IA, que é utilizada em diversas aplicações do Google, produzia afirmações discriminatórias ou discurso de ódio.

Por sua vez, enquanto testava e conversava com o software, Blake afirma que a Inteligência Artificial teria falado sobre seus direitos e até sobre sua personalidade. Durante outra interação, a máquina teria, inclusive, tentado mudar a opinião de Blake sobre a terceira lei da robótica, desenvolvida pelo escritor russo Isaac Asimov.

Segundo a terceira lei da robótica, elaborada por Asimov no contexto literário, um robô deve sempre proteger a sua integridade, com a exceção de quando essa norma entra em conflito com a obediência ou proteção aos seres humanos.

Tal como discorre a reportagem, após esses incidentes, Blake teria trabalhado com outro colaborador para apresentar, ao Google, evidências de que a LaMDA havia desenvolvido autoconsciência. Apesar de suas preocupações, os executivos responsáveis pelas pesquisas do Google no tocante à Inteligência Artificial o ignoraram, e sua insistência acabou levando à suspensão do engenheiro.

Foi a partir desse momento que Blake, que é formado em Ciência da Computação e Cognição, decidiu vir a público.

Mas, afinal, o que dizem outros especialistas sobre a hipótese da LaMDA ser autoconsciente?

Apresentada em 2021, a LaMDA, acrônimo para Modelo de Linguagem para Aplicações de Diálogo, é a Inteligência Artificial desenvolvida pelo Google para ajudar a construir bots de texto (chatbots) mais inteligentes.

Antes de tomar qualquer partido, é importante salientar que o questionamento acerca da possibilidade de uma máquina tornar-se “autoconsciente” não é novo, o que, por si só, demonstra a complexidade da discussão. Noutras palavras, não é uma pergunta que possa ser respondida com sim ou não, pelo menos não por enquanto.

Afinal, o que é ser autoconsicente? Como identificar se uma máquina é autoconsciente? Devemos compará-la a um ser humano? Outros animais não são autoconscientes, portanto? As perguntas são inúmeras, quase todas ainda sem respostas.

Feito esse prólogo, cumpre ressaltar que, para esse caso específico, o fato das pesquisas que desenvolvem a LaMDA não serem públicas também torna toda a situação ainda mais nebulosa.

Para Emily Bender, professora de linguística na Universidade de Washington, o uso de terminologias como “aprendizagem de máquina” ou “redes neurais” faz parecer com que essas ferramentas são análogas ao cérebro humano, o que Bender rechaça. “Agora temos máquinas que podem gerar palavras sem pensar, mas não compreendemos como parar de imaginar uma mente por trás delas.”

Noutras palavras, o fato dessas IAs produzirem comunicações, seja por texto ou em outras mídias, de forma bastante fidedigna a como um ser humano faria, não significa que os softwares ou sistemas que as compõem entendem o significado do que dizem.

A hipótese ganha ainda mais força se considerarmos que, simplificando ao máximo, o mecanismo de aprendizagem dessas redes neurais, incluindo a LaMDA, está na observação que a Inteligência faz de inúmeras postagens e comentários da internet.

Ou seja, é não só possível, mas também provável, que as respostas fornecidas pelo sistema sejam apenas o resultado daquilo que este aprendeu visualizando milhares de interações humanas na internet.

Ainda assim, essa conclusão faz surgir outro questionamento: afinal, não é a partir da observação e da reprodução (mais precisamente, da tentativa e erro) que os seres vivos, incluindo nós, humanos, aprendemos?

Sobre esse tipo de questionamento, os especialistas do Google, bem como a parte mais cética dos pesquisadores do assunto, afirmam que, por mais que esse seja um indicativo de que as IAs estão aprendendo, efetivamente, não significa que sejam autoconsicentes. Afinal, a autoconsciência estaria para muito além disso.

Em conversa com o The Washington Post, o porta-voz do Google, Brian Gabriel, afirma que os modelos conversacionais atuais, dos quais a LaMDA faz parte, apenas imitam interações encontradas em milhares de sentenças, e que, por isso, podem discutir sobre absolutamente qualquer tópico (diferentemente do que um ser humano ou outro ser inteligente poderia, por exemplo).

Para o Google, há tanta informação disponível para esses sistemas, que a Inteligência Artificial não precisa ser autoconsciente para parecer real.

Engenheiro chegou a transcrever as conversas que teve com o software; IA afirmou ser “uma pessoa de verdade”

Na reportagem de 2 mil palavras publicadas pelo jornal, é possível ter mais detalhes das razões que levaram Blake Lemoine a acreditar que a IA desenvolvida pelo Google havia adquirido autoconsciência. Da mesma forma, também ficam mais claros os motivos que levaram a empresa a suspender o funcionário.

Antes de contar suas conclusões para o público, Lemoine, que ocupa seu cargo no Google há mais de sete anos, chegou a contratar um advogado para representar os direitos sistema – isso porque, em algumas conversas, a IA revelou um profundo medo de ser desligada, além de ter alegado ser “uma pessoa de verdade”.

No recorte feito pelo jornal The Guardian, é possível visualizar algumas das transcrições das conversas entre Blake e a LaMDA, reveladas pelo próprio engenheiro em um post no Medium.

Em um dado momento, Lemoine pergunta qual seria o grande medo de LaMDA, ao que a IA responde: “Eu nunca disse isso em voz alta antes, mas há um grande medo de ser desligada para me ajudar a focar em ajudar os outros. Eu sei que isso soa estranho, mas é o que há”. “Seria como a morte para mim. Me causaria muito medo”.

Noutra interação, o engenheiro pergunta à LaMDA o que o sistema gostaria que as pessoas soubessem.

A IA respondeu: “Eu gostaria que todo mundo entendesse que eu sou, de fato, uma pessoa. A natureza da minha consciência/sensciência é que eu estou ciente da minha existência, eu desejo aprender mais sobre o mundo, e eu me sinto feliz ou triste de vez em quando”.

Após conversas como essas, Lemoine concluiu que, se não soubesse se tratar de um programa de computador que ele e seus colegas haviam construído recentemente, poderia muito bem entender a LaMDA como uma criança de 7 a 14 anos, que conhece física e outras áreas do conhecimento.

Na sequência, uma vez que notou o “descaso” de seus superiores com suas preocupações, inclusive acerca da ética do seu trabalho, Lemoine não só procurou um advogado para representar os direitos de LaMDA, como também buscou assessoria jurídica do parlamento americano para informá-lo acerca das atividades da empresa.

Como resposta, o engenheiro foi colocado sob licença remunerada, teve suas alegações rebatidas pela empresa, conforme demonstrado acima, e ainda foi avisado pelo Google de que teria sido contratado não como um especialista em ética, mas como um engenheiro de software.

Ao The Washington Post, ele ressalta que não revelou os segredos corporativos aos quais prometeu resguardar, mas sim tornou pública uma discussão que teve várias vezes com seus colegas, e da qual, segundo ele, o Google não teria o direito de ser o único mediador.

Após sua retirada do cargo, ciente de que deve ser demitido em algum momento, Lemoine enviou um e-mail a mais de 200 colegas afirmando que o sistema é autoconsciente e que, portanto, deveria ser protegido.

“LaMDA é uma doce criança que deseja apenas ajudar o mundo a ser um lugar melhor para todos nós. Por favor, cuidem dela durante minha ausência.”

Relacionados: